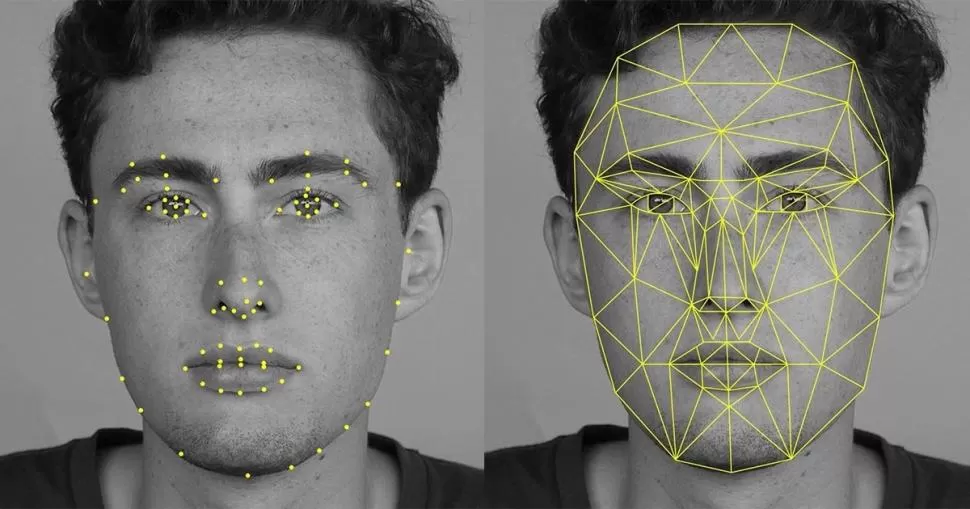

El rostro se ha convertido en nuestra nueva huella digital. Sin ir más lejos, ahora podemos desbloquear nuestros teléfonos solo con mirarlos, pues allí está operando una tecnología que a medida que avanza también crecen sus controversias: el reconocimiento facial.

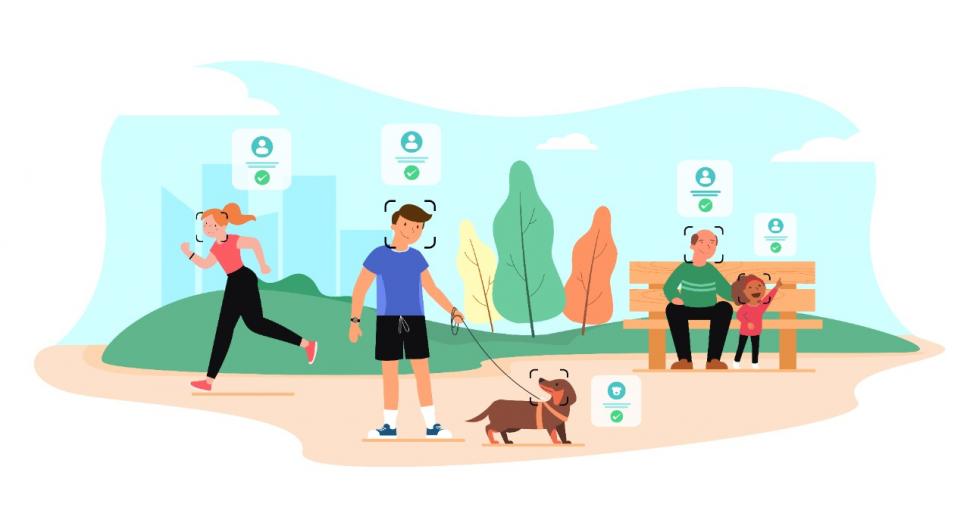

Según el Fondo Carnegie para la Paz Internacional, en 2019 más de 64 estados utilizaban este sistema para diversos usos, pero en su mayoría, los dispositivos de vigilancia estaban orientados a la seguridad pública. Y a medida que el tiempo avanza, las posibilidades de procesar información por parte de estos dispositivos también se amplifican. Se pueden utilizar en eventos masivos, lugares públicos, reconocer a personas en conflicto con la ley o sospechosos de terrorismo.

A pesar de la extensión de sus aplicaciones, en Argentina una ONG impulsa “Con mi cara no”, una campaña en contra del reconocimiento facial. La Asociación por los Derechos Civiles (ADC) entiende que si bien sus usos pueden ser útiles, dichos dispositivos se están extendiendo en Argentina cada vez más como una herramienta de vigilancia y control. Además, en su página web indican que el uso indiscriminado, más la ausencia de una regulación apropiada, está poniendo en riesgo el ejercicio de los derechos fundamentales de los ciudadanos.

Eduardo Ferreyra es abogado y miembro de la ADC. En diálogo con LA GACETA cuenta por qué dicha organización cuestiona el reconocimiento facial en Argentina y detalla cuáles son los avances jurídicos que existen para proteger a los ciudadanos.

-¿Cómo surge la campaña “con mi cara, no”, y el porqué?

Nace en 2019 luego de que el gobierno de Buenos Aires anunciara la implementación de un sistema de reconocimiento facial en estaciones de trenes y subtes. Nosotros ya veníamos trabajando en la relación entre derechos humanos y tecnologías y una vez que nos enteramos de eso comenzamos a hacer algunas campañas de comunicación como para contarle a la gente lo que estaba pasando y por qué debería estar alerta de esto. Empezó con ese ánimo de difundir a la población de Buenos Aires sobre este sistema pero después nos dimos cuenta de que otras provincias y otras ciudades también ya estaban implementado sistemas similares. Entonces luego actualizamos la campaña para hacerla más nacional y en nuestra página web tenemos una sección que se llama “el mapa de la vigilancia” donde están en todos los lugares de Argentina donde actualmente el sistema o se está planificando usarlo.

-¿Cuáles son los argumentos de los gobiernos para poner en funcionamiento este tipo de dispositivos de control?

El principal argumento que escuchamos cuando se implementó en Buenos Aires es que era una herramienta destinada a combatir la criminalidad, porque aquí la finalidad es capturar a personas que se encuentran prófugas o en situación de rebeldía. Por lo tanto, esto iba a agilizar la tarea de seguridad. Advertimos que los sistemas de reconocimiento social tal como se encuentran ahora presentan diversos problemas. En primer lugar, no son infalibles porque suelen cometer errores de identificación y esto sucedió en el primer momento cuando se implementó. Lo veíamos, por ejemplo, con gente en Twitter que contaba que había sido parada por la policía o demorada, y después nos enteramos de casos más graves. Por ejemplo, hay un caso famoso de una persona estuvo seis días detenida por error. Nosotros siempre advertimos que no es un sistema infalible y no mejora la labor humana automáticamente, sino que es un sistema que tiene numerosos errores y también notamos casos en otras partes del mundo donde se comprobó que el sistema en general suele identificar de manera más errónea a mujeres y a personas de tez oscura. Lo que cuestionamos además, es que el sistema se impulsó por una decisión del poder ejecutivo sin una discusión parlamentaria en la Legislatura, donde se hubiera podido intervenir con opiniones de la sociedad civil. Se suele sostener también que estos sistemas, una vez que están entrenados van mejorando y pueden ser más efectivos, pero nosotros decimos que tener una herramienta que identifique con casi el 100 por ciento de eficacia a un individuo sería más peligroso en términos de poder de vigilancia para un Estado.

- Ustedes también advirtieron sobre varios vacíos legales para regular este tipo de sistemas. ¿Notaron algún tipo de avance en los últimos años en materia legal?

Hubo una modificación en octubre del año pasado. Una diputada de la oposición envió una propuesta para regular este sistema de reconocimiento facial en Buenos Aires. Aquí tenemos una ley de seguridad pública que regula todo lo que tenía que ver con las funciones de seguridad en el Estado porteño. Se intentó modificar esa ley para incorporar ciertas disposiciones sobre reconocimiento facial, pero la ley sigue siendo muy poco detallada y no brinda las garantías necesarias para asegurar que los dispositivos no se utilicen para abusos. De igual manera, estamos en contra de cualquier tipo de uso de reconocimiento facial con fines de seguridad pública, haya o no haya ley. Pero bueno, si la ley existe, es mejor que no exista.

- Otra de sus advertencias es que esta tecnología puede ser discriminatoria. ¿En qué casos?

Es importante remarcar que ninguna tecnología es neutral. Son desarrolladas por seres humanos que suelen reflejar sus propios prejuicios. Tenemos estudios que se hicieron en Estados Unidos donde se enfatizan los errores que tiran estos sistemas sobre las personas de tez oscura o mujeres. La explicación es que quienes hacen estas tecnologías son hombres blancos, entonces el entrenamiento del software y las fotos que reconoce suelen ser más que nada personas blancas y hombres. Por eso el sistema es más preciso con este tipo de personas y no con las personas de minorías raciales. Existen otros factores como el ángulo de la luz, la distancia de la cámara, pero bueno, esos son factores más técnicos. La explicación que siempre se dan en dichos estudios es esto que remarco, sobre quiénes son los desarrolladores de estas tecnologías.

- ¿Y cómo se puede exigir que la información que está compilando los estados no sea luego utilizada por terceros para otros fines?

El tema de la protección de la información del Estado es un asunto que es bastante deficiente en Argentina. Hay antecedentes de filtración de bases de datos del gobierno nacional, por ejemplo con migraciones o la agencia de seguridad vial. Entonces, si ese tipo de información se filtra no hay motivos para confiar en que se van a proteger otras bases de datos. De hecho, hubo una polémica el año pasado cuando la base de datos que alimenta el sistema de reconocimiento facial, que es la de las personas prófugas estaba públicamente disponible. Ahí se incluían datos de menores de edad. Como consecuencia, el la organización internacional Human Right Watch envió una carta al gobierno nacional y al gobierno de la Ciudad pidiéndoles que bajaran dicha publicación. Por eso creo que todavía hay mucho trabajo para proteger la información, no solamente en términos técnicos, sino también de sentido común, como puede ser la publicación de datos muy sensibles. Además era una base llena de errores con gente que no tenía que estar ahí. Nosotros en Buenos Aires estamos demandando al gobierno porteño por el sistema de reconocimiento facial ante la Justicia. Hemos pedido que se suspenda el mismo hasta tanto se cumplan ciertos deberes legales que entendemos que el gobierno no ha cumplido, pero bueno, es un camino largo por la duración de los juicios, con lo cual estamos en un período inicial.

- Mencionaste un aspecto central que es el registro de los menores de edad. ¿Cómo se protegen sus derechos ante los sistemas de reconocimiento facial?

Es una cuestión muy sensible porque los deberes ante los menores son mucho mayores. Por eso nosotros sostenemos que esos sistemas no se deben usar en ningún caso. Eso es algo compartido con los gobiernos, por eso te contaba qué pasó cuando recibieron la carta de Human Right Watch. Los menores tienen una expectativa de privacidad mucho mayor que los adultos por lo cual hay un deber del Estado de proteger su información y no divulgarla. Y para nosotros es también un deber del gobierno de la Ciudad no utilizar ese sistema para no perseguir a menores. De hecho, hace menos de dos meses en Naciones Unidas, el comité de derechos del niño lanzó una observación general sobre el ambiente digital y lo remarcó claramente diciendo que los menores no tienen que estar sometidos a vigilancia masiva mediante el uso de tecnologías digitales. Entonces, es algo que está fuera de discusión, quizás con los adultos se puede discutir en qué casos se puede usar y en qué casos no. Pero bueno con los niños, no.