Así como la inteligencia artifcial puede se runa herramienta últil, su tecnología cada vez más sofisticada peude caer en las manos incorrectas. La situación llegó al FBI que estuvo adviertiendo al público sobre un tipo de ciberataque cada vez más peligroso que puede engañar incluso a los más experimentados en la materia.

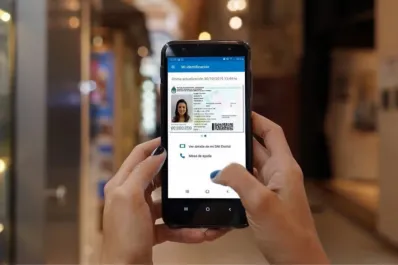

La revista Forbes publicó una actualización de su informe realizado en 2020 sobre los nuevos ciberataques y delitos que incorporan a la IA como técnica criminal. En el artículo, se advierte por una nueva modalidad: los ataques deepfake ue afectan a los usuarios de smartphones, a pesar de los esfuerzos de empresas como Google y otras para defenderse. Las téncias son tan convincentes que expertos en seguridad, incluido el FBI recomiendan tomar medidas drásticas.

La inquietante y cada vez convincente estafa con IA

Se trata de las llamadas de estafa realziadas con deepfake. Las falsificaciones de voz, impulsadas por IA, empezaron a ganar popularidad después de un artículo viral de Fobes publicado en 2024 sobre un experto en seguridad que casi fue engañado, con consecuencias potencialmente muy costosas.

Adrianus Warmenhoven, experto en ciberseguridad de NordVPN, se ha sumado a las voces que advierten a los usuarios de iPhone y Android sobre esta amenaza. "Los estafadores telefónicos utilizan cada vez más herramientas de clonación de voz para sus actividades fraudulentas, ya que este tipo de software se volvió más asequible y eficaz con el tiempo", comentó Warmenhoven a Forbes. Un método común, que se observa en los ataques actuales, es usar este audio deepfake para "contactar a los familiares de la persona por la que se hacen pasar", explicó Warmenhoven, "y extorsionarles simulando una emergencia".

Las medidas que recomiendan desde el FBI: colgar y crear códigos secretos

El FBI llegó incluso a emitir la alerta de servicio público número I-120324-PSA sobre este mismo tema. Tanto la agencia como Warmenhoven recomiendan la misma medida de mitigación, por brutal y alarmante que suene: colgar el teléfono y crear un código secreto que solo conozcan sus familiares y amigos cercanos.

Para mitigar el riesgo de estos sofisticados y cada vez más peligrosos ataques de IA contra usuarios de iPhone y Android, el FBI indicó que las personas deben colgar el teléfono inmediatamente si reciben una llamada que dice ser de un familiar o amigo cercano pidiendo dinero de esa manera, y verificar la identidad de la persona que llama utilizando medios directos usted mismo.

La agencia de inteligencia también advirtió que todos los miembros del público deben crear una palabra o frase secreta que solo usted y sus contactos cercanos conozcan y usarla para identificar a una persona que dice ser alguien en problemas, sin importar cuán convincente suene. Y convincente será, ya que la llamada deepfake se basará en clips de audio públicos, de videos de redes sociales, por ejemplo, que luego se alimentan a través de herramientas de IA para producir, en efecto, que esa persona diga cualquier cosa que se escriba.