Alejandro Urueña

Ética e Inteligencia Artificial (IA) - Founder & CEO Clever Hans Diseño de Arquitectura y Soluciones en Inteligencia Artificial. Magister en Inteligencia Artificial.

José N. Farhat

Abogado, especialista en derecho procesal con orientación penal (Fac. Derecho - UNT).

La noticia de la futura salida del modelo o3 podría resolver problemas complejos al nivel de un doctorado (https://x.com/OpenAI/status/1870164871289155937), pero parece que todavía no ha aprendido a identificar a un depredador digital en su hábitat natural. Será que la inteligencia artificial avanza más rápido en impresionar a inversionistas que en proteger a quienes más lo necesitan. Bienvenidos al futuro, donde la ética corre siempre un paso detrás del algoritmo.

No existen dudas de que la tecnología está cambiando nuestra vida, hoy se ha avanzado hacia una nueva etapa de la revolución digital (tiempos de inteligencia artificial, internet de las cosas y blockchain), la cual se entrelaza con un nuevo momento evolutivo de la persona humana. Esto trae consigo grandes beneficios y oportunidades. Sin embargo, existe en nuestra exposición en el territorio digital, riesgos, vulneraciones y amenazas. En esto la prevención es clave para enfrentar los desafíos de este nuevo territorio, que compone la realidad. Estamos expuestos no solo a personas malintencionadas o contenidos diseñados que buscan que pensemos, siéntanos o hagamos algo, sino también a nuevos modelos de tecnología, como la inteligencia artificial (IA), donde ya no interseccionamos con una persona o con un contenido, sino con un perfil de inteligencia artificial que contempla mayores capacidades para vincularse con las personas, lo que requiere que estemos siempre advertidos. Comprender estas amenazas nos permite protegernos de riesgos como la manipulación, la vulneración de datos y los delitos digitales.

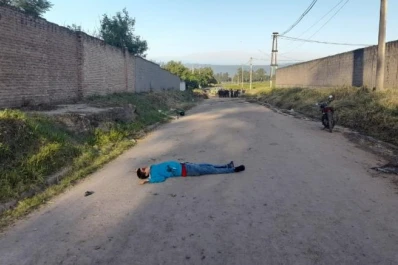

Un caso reciente de grooming ilustra los riesgos que enfrentamos. Desde 2013, el grooming está tipificado como delito en nuestra legislación, describiendo situaciones en las que una persona mayor de edad deliberadamente genera un vínculo con un menor de edad, por medio de tecnología para cometer cualquier delito contra su integridad sexual.

Este delito puede desarrollarse en varias etapas o en una sola. En un primer momento, el groomer selecciona a la víctima en redes sociales, juegos en línea o foros, identificando vulnerabilidades. Luego, establece confianza mediante conversaciones amables, adoptando incluso identidades falsas (aunque no siempre es falsa). A continuación, intenta aislar a la víctima de su entorno cercano, fomentando secretos y exclusividad en la relación. Una vez ganada su confianza, persuade al menor para compartir contenido personal o íntimo, que posteriormente utiliza para chantajearlo o intimidarlo. Finalmente, puede intentar concretar un encuentro físico o continuar explotando a la víctima en línea.

Hoy, estas manipulaciones se ven simplificadas y potenciadas por la IA, dado la posibilidad de hacer lecturas de los perfiles digitales de forma más veloz, y en tiempo real, generando mayores estrategias de abordaje para la comisión de delitos. En un caso que está investigando la justicia porteña, un acosador utilizó inteligencia artificial para generar imágenes falsas de una menor de edad sin ropa. Con estas imágenes, el imputado extorsionó a la víctima, coaccionándola emocionalmente. Este ejemplo deja en evidencia cómo la IA puede ser empleada como herramienta para a prima facie, configurar el comportamiento de una figura delictiva como la que contempla el código penal en el artículo 131.

El avance de la tecnología ha transformado nuestra forma de vivir, trabajar y relacionarnos. Las capacidades aumentadas que nos da este nuevo entorno, nos brinda grandes beneficios y oportunidades, sin embargo también amplifica las amenazas, ya que no todas las personas son quienes dicen ser, no todo contenido es inocente y neutro, sumado a que no toda fotografía representa una foto de personas reales. Los acosadores, como los groomers, estudian a sus víctimas con técnicas que moldean su comportamiento para influir en cómo piensan, sienten y actúan. Esto no solo ocurre con personas malintencionadas, sino también con las interfaces digitales que usamos diariamente. Diseñadas de manera persuasiva, estas interfaces recopilan nuestros datos, personalizan nuestras experiencias y orientan nuestras decisiones de manera sutil.

Las plataformas digitales emplean algoritmos que nos muestran contenido basado en nuestras preferencias, pero también pueden manipular nuestras emociones y decisiones, en base a los datos que vamos dejando y creando nuestra huella digital, existiendo la posibilidad de que se utilice de forma exponencial en nuestra contra. Por ejemplo, pueden influir en qué compramos, cómo nos sentimos o en cómo realizamos nuestras interacciones en línea. Esta capacidad también es explotada por agentes maliciosos que buscan aprovechar nuestras vulnerabilidades.

En este contexto, la inteligencia artificial es una herramienta poderosa, pero también puede ser utilizada con fines ilícitos. Desde la creación de imágenes falsas hasta la manipulación de información y conductas, la IA amplía las capacidades de los ciberdelincuentes. La exposición a manipulación y riesgos digitales no es un fenómeno aislado; es parte de una realidad que requiere atención y estrategias efectivas de protección de las personas.

En este sentido, la ciberseguridad no debe entenderse únicamente como la protección de infraestructuras, datos y redes, sino también como la seguridad de la persona humana. Esto implica reconocer que somos importantes y que debemos desarrollar habilidades para identificar amenazas provenientes de otras personas, de contenidos engañosos y de la inteligencia artificial. Ante esto, se hace necesario incorporar paradigmas como el de confianza cero, la ciberhigiene y el pensamiento crítico. Esto implica proteger nuestras contraseñas, evitar la sobreexposición de datos personales y construir hábitos saludables, son algunos pasos esenciales para mantenernos seguros.

La mejor estrategia para abordar estos desafíos es desarrollar una cultura de prevención basada en la estrategia de ciudadanía digital, donde la alfabetización múltiple y el pensamiento crítico, ocupan un lugar de privilegio. La alfabetización digital, la cual se encuentra dentro de la alfabetización múltiple, no se limita a aprender a usar dispositivos o aplicaciones. Se trata de comprender cómo interactuar de manera responsable y segura en entornos digitales. Este proceso incluye proteger nuestra privacidad y nuestros datos personales, reconocer señales de manipulación en plataformas digitales y entender cómo nuestras interacciones generan patrones de comportamiento que pueden ser utilizados en nuestra contra. También es fundamental desarrollar competencias para identificar noticias falsas, distinguir entre hechos y opiniones, y evaluar la fiabilidad de la información en línea. Este enfoque no solo protege a los ciudadanos digitales de la desinformación, sino que también los habilita para contribuir con ideas fundamentadas en la convivencia digital.

Otro elemento clave es la implementación del paradigma de confianza cero, una estrategia que asume que ningún usuario, dispositivo o servicio debe ser considerado seguro por defecto, incluso dentro de redes internas, esto implica que la confianza no se otorga, sino más bien se gana. Esta aproximación moderna a la seguridad permite proteger el patrimonio digital, que incluye desde dinero hasta la reputación personal. En un mundo saturado de información, adoptar una actitud crítica y preventiva es esencial para evitar manipulaciones y mantener nuestra autonomía como individuos.

Por último, es importante destacar que la protección en el entorno digital no es solo una responsabilidad individual, sino también un esfuerzo colectivo. La construcción de una ciudadanía digital robusta implica la colaboración entre usuarios, estados (en todos sus niveles), academias y empresas tecnológicas. Esto requiere no solo herramientas y estrategias técnicas, sino también un compromiso activo para fomentar una cultura de prevención en los entornos digitales, pensamiento crítico y la alfabetización múltiple. Cada uno de nosotros tiene un rol importante en los desafíos de este tiempo. Entender que estamos expuestos a técnicas de manipulación y diseños persuasivos nos permite tomar el control de nuestras decisiones y construir un entorno digital más seguro y humano para todos. Al priorizar la prevención, no solo cuidamos nuestros datos, sino también nuestra autonomía, seguridad y dignidad como personas en el mundo digital, convirtiendo nuestra intersección con la tecnología, en significativa.

Desde un punto de vista técnico, la creación de imágenes falsas a través de inteligencia artificial utiliza redes neuronales generativas, como las Generative Adversarial Networks (GANs), que tienen la capacidad de producir imágenes extremadamente realistas a partir de datos entrenados. Estas redes funcionan mediante la competencia entre dos algoritmos: uno que genera imágenes falsas y otro que las evalúa, mejorando progresivamente la calidad de las imágenes generadas. El resultado es una imagen convincente, que puede parecer una fotografía real, pero que ha sido completamente fabricada, sin ninguna relación con la persona o situación que se representa.

Este tipo de tecnologías tiene un gran potencial para crear contenido visual que engañe a los observadores, amplificando los riesgos de manipulación. La precisión con que las IA pueden reconstruir detalles faciales, expresiones y entornos hace que sea difícil distinguir entre lo real y lo creado, abriendo la puerta a una variedad de delitos, desde el grooming hasta la suplantación de identidad. La posibilidad de generar imágenes o videos de personas en situaciones comprometedoras sin su consentimiento pone de manifiesto la necesidad urgente de desarrollar herramientas más avanzadas para la detección y verificación de contenido digital. Por supuesto, las grandes tecnológicas no se apresurarán a tomar acción. ¿Para qué? Si crear un entorno inseguro alimenta la demanda de nuevas soluciones, y qué mejor que ofrecer la “seguridad” en un mercado que ya domina el caos digital. Reiteramos el concepto de responsabilidad parece tan flexible como la ética de sus algoritmos.