En las últimas dos semanas, amigo lector, hemos explorado el impacto de la Inteligencia Artificial (IA) en el futuro del trabajo. Analizamos el experimento social de la Renta Básica Universal, la necesidad de adaptarnos a un mundo en constante cambio y la amenaza de una nueva desigualdad.

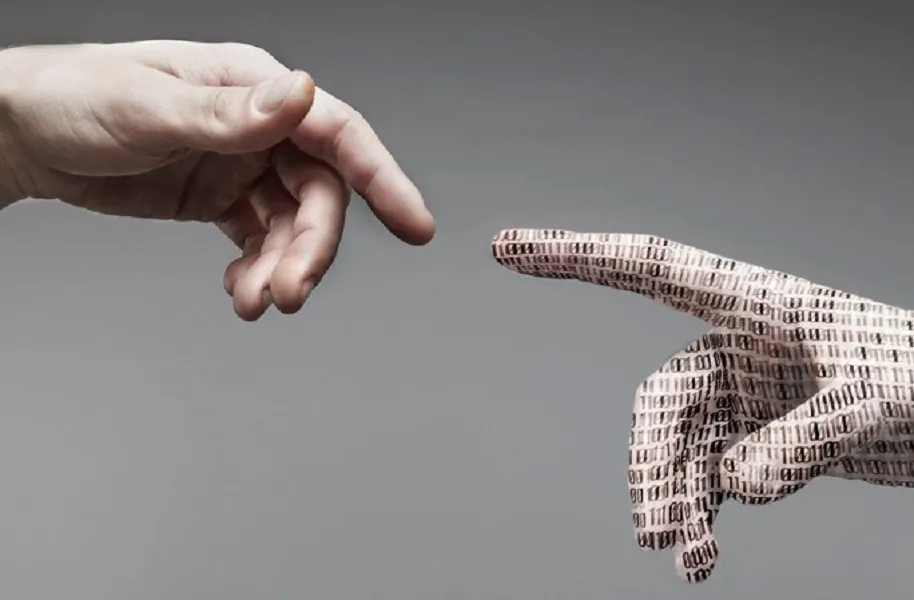

Pero hay una dimensión aún más profunda que debemos abordar: la dimensión ética. ¿Estamos jugando a ser dioses, delegando nuestra moral a algoritmos? El dilema del vehículo autónomo: una decisión imposible. Imaginemos un escenario, no tan lejano, en el que un vehículo autónomo circula a gran velocidad por una avenida Mate de Luna. Nada que no se aleja a nuestra realidad. Seguimos siendo un poco incivilizados al volante. Ahora imaginemos que es un Tesla (Auto eléctrico y autónomo).

De repente, un niño cruza la calle sin mirar, justo en la trayectoria del vehículo. Al mismo tiempo, un adulto mayor camina por la acera en el lado opuesto. El sistema de IA del vehículo detecta la situación y calcula que solo tiene tiempo para esquivar a una de las dos personas. ¿Qué decisión debería tomar? ¿Priorizar la vida del niño, asumiendo que tiene un futuro más largo por delante? ¿O proteger al adulto mayor, valorando su experiencia y sabiduría acumulada?

¿Hay una respuesta “correcta” en este dilema? ¿Quién decide qué vida vale más? ¿Un algoritmo? ¿Un programador? ¿Una empresa? Este escenario, que hoy parece sacado de una película de ciencia ficción, nos enfrenta a la cruda realidad de la ética en la IA. Nos obliga a preguntarnos: ¿Estamos preparados para delegar decisiones de vida o muerte a las máquinas? ¿Podemos programar la ética en un algoritmo?

Imaginemos un futuro donde los algoritmos toman decisiones cruciales en áreas como la salud, la justicia, la educación e incluso la política. Un médico que recibe el apoyo de un sistema de IA para diagnosticar una enfermedad. Un juez que utiliza un algoritmo para determinar la sentencia de un acusado.

La Era de la Humanidad Aumentada nos obliga a repensar la responsabilidad, la transparencia y la rendición de cuentas en un mundo donde las decisiones ya no son tomadas solo por humanos, sino por humanos asistidos. ¿Cómo podemos garantizar que los sistemas de IA sean justos, imparciales y que no perpetúen los sesgos existentes en nuestra sociedad?

La IA y la Búsqueda del Bien Común: ¿Progreso para Quién? La tecnología no es neutral. Es una herramienta que puede ser utilizada para el bien o para el mal. En esta nueva era, debemos preguntarnos: ¿Para quién estamos creando este futuro? ¿Para unos pocos privilegiados, para las grandes corporaciones tecnológicas, o para el bien común?

La IA tiene un potencial enorme para resolver problemas globales como la pobreza, el hambre, las enfermedades y el cambio climático. Imaginen sistemas de IA que optimicen la distribución de alimentos, que desarrollen nuevos medicamentos, que diseñen sistemas de energía limpia y que nos ayuden a comprender y combatir el cambio climático.

Pero esa misma tecnología también puede ser utilizada para aumentar el control, la vigilancia, la manipulación y la desigualdad. Imaginen sistemas de IA que controlen nuestras vidas, que nos vigilen constantemente, que manipulen nuestras emociones y que perpetúen los sesgos existentes en nuestra sociedad.

La ética debe ser el faro que guíe nuestro camino en esta nueva era. Debemos asegurarnos de que la IA se utilice para mejorar la vida de todas las personas, no solo para beneficiar a unos pocos.

Amigo lector, el futuro de la humanidad no está escrito en algoritmos. Está en nuestras manos. ¿Qué mundo queremos construir? ¿Un mundo donde la tecnología nos deshumaniza o un mundo donde nos ayuda a ser más humanos? ¿Un mundo donde las máquinas nos dominan o un mundo donde las dominamos nosotros?

La decisión es nuestra

Te invito a reflexionar sobre el impacto ético de la IA y a participar en la construcción de un futuro donde la tecnología esté al servicio de la humanidad, no al revés. Comparte tus ideas en el foro de LA GACETA. Tu voz es importante.